Originalmente publicado en: De la inducción y la deducción – Todo suma

Imagen: Karl Popper (1902 – 1994) en su casa de Londres, en una foto de 1992. David Levenson (GETTY IMAGES)

Introducción a la inducción

La noción de eventos impredecibles con consecuencias trascendentales ha ido ganado prominencia con rapidez en el imaginario colectivo. Ya no es necesario explicar conceptos como el «cisne negro», popularizado por Nassim Nicholas Taleb, que recuerda que, a pesar de la sensación de seguridad que puedan ofrecernos los avances tecnológicos y científicos, seguimos expuestos a fenómenos inesperados que desafían nuestras suposiciones más básicas. La pandemia mundial por SARS-CoV-2, por ejemplo, evidenció la fragilidad de algunas de nuestras certezas y, momentáneamente, obligó a todo el planeta a replantearse cómo entender y proyectar el futuro.

En este contexto, es relevante reflexionar sobre los métodos en los que se basa la generación de tales certezas y, en general, el conocimiento. Y es que quizás no sea necesario explicar qué es un evento del tipo cisne negro pero sí la inducción —esa idea de que podemos inferir reglas generales a partir de observaciones particulares— pues parece estar muy latente en gran parte de cómo se comprende el mundo.

La inducción es una de las herramientas más antiguas y fundamentales para construir conocimiento científico, y se basa en la idea de que desde observaciones particulares se puede llegar a generalizaciones universales. Este concepto, aunque aparentemente intuitivo, ha sido examinado críticamente por autores como Francis Bacon, David Hume y Karl Popper, quienes revelaron algunos de sus límites y desafíos. Aquí la mención a tres filósofos no es casual, cuando escuchen aquello de “pero es que la Filosofía no sirve de nada”, recuerden que entre otras muchas cosas ha ayudado a definir lo que es la ciencia.

Francis Bacon fijó lo que definiríamos como la base empírica de la inducción: que ésta parte de la recopilación de evidencias utilizando nuestros sentidos. En su Novum Organum (1620), propuso un método inductivo sistemático para tratar de obtener conocimiento fiable y superar los prejuicios regentes durante su época. Según esta perspectiva, al observar repetidamente un fenómeno bajo las mismas condiciones, podemos inferir una regla general. Por ejemplo, tras observar que todos los cisnes conocidos son blancos, podemos inferir que «todos los cisnes son blancos» ¿Le suena? Gracias a esta metodología se produjeron muchos avances científicos, permitiendo a los investigadores pasar de hechos aislados a teorías generales que explicasen y predijesen fenómenos. Pero este enfoque no viene libre de problemas, y no pocos precisamente.

David Hume, en el siglo XVIII, planteó en Una investigación sobre el entendimiento humano (1748) lo que él consideraba (quizás también generalizando optimistamente que sólo habría uno) el problema fundamental de la inducción: no existe una garantía lógica para suponer que el futuro será como el pasado. (Si le interesa podemos hablar sobre lógica en más detalle en otro artículo). Quiénes hayan leído a Taleb recordarán el ejemplo del pavo (originalmente de Bertrand Russel, del que también hablaremos otro día) que es alimentado y cuidado cada día y asume que eso siempre será así, hasta que llega el día en que hay pavo en el menú. El problema lógico, con otro ejemplo que resuene más con su experiencia, se podría formular de la siguiente manera.

Utilizando como referencia una deducción perfectamente lógica.

- Todos los artículos de este autor son inútiles.

- Este artículo es del mismo autor

——————————————————————————————— - Este artículo es inútil.

Se puede apreciar el problema lógico que acarrea la inducción si ahora la premisa 1 se basa en la observación subjetiva.

- Todos los artículos que ha leído hasta ahora de este autor le han resultado inútiles.

- Este artículo es del mismo autor

——————————————————————————————— - Este artículo es inútil.

El problema de Hume radica en que la experiencia, per se, no asegura que algo se repita en el futuro. Además el avezado lector puede entrever del ejemplo que la subjetividad asociada a la experiencia de los observadores puede causar otros problemas. Por ejemplo los observadores europeos descartaron la posibilidad de que existiesen cisnes de otro color que no fuese blanco y estaban equivocados por motivos distintos al que apunta Hume, dado que ya existía experiencia al respecto, salvo que en otro continente.

Volviendo al filósofo, éste argumentó que nuestras inferencias inductivas no son racionales en un sentido lógico, sino hábitos de pensamiento basados en nuestra experiencia pasada. Este cuestionamiento plantea un desafío profundo: si no podemos justificar la inducción, ¿cómo sustentamos la ciencia y todas nuestras certezas?

Para Karl Popper la respuesta era sencilla: hay que rechazar la inducción como fundamento del conocimiento científico. En La lógica de la investigación científica (1934) propuso el falsacionismo, proceso por el cual las teorías no se confirman inductivamente, sino que han de someterse a pruebas para refutarlas. Esto salva el escollo lógico, puesto que la fuerza de la evidencia se aplica para rechazar una teoría, punto de partida del proceso, y es mucho más sencillo porque basta con una evidencia contraria.

- Todos los artículos de este autor son inútiles.

- Este artículo es del mismo autor y me ha resultado útil.

——————————————————————————————— - No todos los artículos de este autor son inútiles.

De esta manera Popper defiende que cuanto más concreta sea una teoría científica, más valor aporta, porque sería más fácil de refutar y hará que la ciencia avance. Sirva como ejemplo la siguiente teoría: Cada día es posible que llueva. No es falsable, dado que la premisa acomoda cualquier tipo de evidencia, y por tanto no sería una buena teoría científica porque no nos acerca al conocimiento de cómo funciona el mundo. Por ello acabó desencantándose de la idea de que la ciencia es el no va más porque se deriva de hechos, en especial del “cuantos más mejor” tan propio del inductivismo y que daba pie a freudianos y marxistas para acomodar e interpretar a su antojo un amplio rango de ejemplos del comportamiento humano y cambios históricos. Para él, muchas de estas teorías no eran falsables ya que daban cabida a cualquier evidencia, haciéndolas inútiles. Dejándolas a la misma altura que una vaga adivinación del horóscopo que abre la puerta a cualquier evento. Es precisamente, según él y sus seguidores, a través de hipótesis falsables como se puede hacer evolucionar la ciencia, no acumulando hechos, sino usándolos para descartar hipótesis incorrectas.

Esto, pese a su atractivo y buena intención, añade algunos problemas más sobre los que se tenían hasta el momento, sin ir más lejos: ¿cómo se validan las premisas utilizadas para falsar una teoría? ó ¿qué parte queda falsada cuando se presenta una prueba contraria? Por ello le pido permiso para dejar aquí el falsacionismo y la evolución de la filosofía de la ciencia, y avanzar unos pocos años hasta el día de hoy. Pero quédese con la importancia de comenzar por tener una teoría.

Aunque el inductivismo puro ya no es aceptado como modelo exclusivo, su influencia sigue siendo mayúscula ya que la formulación de muchas hipótesis aún depende de la observación sistemática. Sin embargo, se reconoce que la inducción necesita complementarse con enfoques deductivos y teóricos.

Deducción: De Teorías a Predicciones

La deducción, en contraste con la inducción, comienza con una hipótesis o teoría para desde ella derivar predicciones que pueden ser puestas a prueba. Es posible que le suene este enfoque por ilustres figuras como René Descartes (otro filósofo, para sorpresa de nadie). Es por tanto una buena herramienta para complementar el proceso inductivo y llegar a explicaciones más ajustadas a la realidad que tengan también en cuenta otros aspectos, tales como leyes o teorías adicionales, o contraejemplos que refuten una visión sesgada.

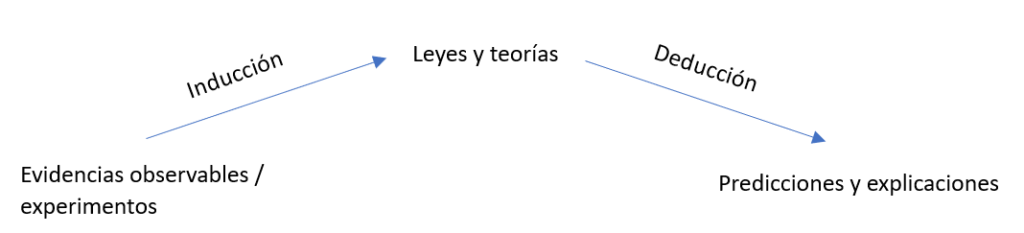

En la siguiente figura se esquematiza el proceso total que combina ambos enfoques.

Esto a su vez nos brinda otros problemas:

- Dependencia de teorías previas: Las deducciones se fundamentan en premisas que pueden estar equivocadas. Si las bases son incorrectas, las conclusiones también lo serán.

- Limitaciones prácticas: A menudo no es posible encontrar evidencias lo suficientemente específicas o replicables como para refutar o confirmar una teoría compleja. Además el uso de modelos simplificados puede ayudar en ocasiones, pero también ignorar elementos clave. Puede que le suene el término “econ” u “homo economicus” que se utiliza en economía y asume que los humanos somos racionales.

- El riesgo del dogmatismo: La deducción orientada a objetivos concretos junto al uso de modelos puede hacer que se ignoren variables y observaciones contradictorias para proteger una teoría que es a priori válida para muchos otros casos. Como por ejemplo las reticencias originales hacia la relatividad especial por su confrontación con la mecánica de Newton.

Pese a ello la deducción es esencial en la ciencia moderna, especialmente en disciplinas como la física teórica y las matemáticas. Sin embargo, se aceptan sus limitaciones y por ello las predicciones han de ayudarse de probabilidades y deben estar acompañadas de un ciclo constante de revisión empírica. Esto es seguramente lo que hace que el método científico sí sea el “no va más” porque abraza la incertidumbre y se abre a avanzar con un ciclo interminable de revisiones hacia un conocimiento más robusto de la realidad (hasta que se demuestre lo contrario).

¿Y la inversión?

Si nos centramos en nuestra parcelita de la inversión, es común analizar el pasado para intentar predecir el futuro. Métodos esotéricos como el análisis técnico, que se centra en patrones históricos de precios y volúmenes, y otros como el respetado descuento de flujos de caja (DCF), que proyecta estimaciones de los ingresos futuros para determinar el valor presente de un activo, parten de una lógica inductiva. Observan lo que ha ocurrido previamente, se centran en algunas métricas y extrapolan tendencias o relaciones hacia lo que podría suceder. En este sentido, la inducción es uno de los pilares de gran parte del análisis financiero.

Sin embargo, dar el salto hacia una deducción que soporte el paso del tiempo parece extremadamente complejo, si no imposible a día de hoy. La economía y los mercados financieros son sistemas dinámicos complejos e impredecibles, influenciados por múltiples variables externas como la política y las emociones humanas. Incluso las deducciones más sofisticadas, basadas en premisas aparentemente sólidas, pueden fallar frente a eventos inesperados o cambios estructurales en el mercado. Este desafío resalta las limitaciones de cualquier enfoque estrictamente deductivo en finanzas.

Por un lado puede indicar una limitación deductiva a la hora de definir los modelos y teorías correctamente, por ejemplo si se dejan fuera variables relevantes. O, por el contrario (o incluso simultáneamente), un problema inductivo por no poder definir la evidencia y no diferenciar señal de ruido. En cualquier caso la necesidad de una adaptabilidad constante es latente.

Sirva como ejemplo una de las teorías más sencillas como la inversión por factor momento —comprar activos que han mostrado un rendimiento reciente positivo y vender aquellos con rendimientos negativos, bajo la tesis de que estas tendencias tienden a continuar a corto plazo— sobre la que existe mucha literatura. Esta estrategia, que muestra históricamente resultados positivos, parte de la honestidad de no poder predecir cuándo ocurrirá algo (cambio de tendencia), pero promete lucrarse durante los periodos hasta que se produzca. La evidencia base de los artículos en los que se estudia está perfectamente definida y estos han pasado por revisión exitosamente. Podría parecer que problema deductivo por tanto, en base a dicha información y por la sencillez de las premisas, fuese menor, pero no lo parece tanto si se tienen en cuenta las revisiones que se han necesitado desde que Jegadeesh y Titman diesen la definición original en 1993, entre otras :

- La duración del momento necesario se ha ido redefiniendo para adaptarse a mercados más complejos.

- Varias revisiones sobre la frecuencia de reequilibrio o revisión periódica.

- Surge la necesidad de protegerse frente a un posible riesgo sectorial tras la burbuja de las .com. Dejando claro un riesgo latente ante eventos del tipo cisne negro.

- Se observa una dependencia hacia el tipo de mercado: funciona mejor en mercados “suaves” y estables que en momentos de volatilidad alta donde la tendencia se rompe con facilidad.

Además:

- No se puede definir una causalidad universal ya que para cada mercado, producto, divisa y periodo la mejor estrategia ha podido y puede diferir y no es posible asegurar repetición en el futuro.

- Puede darse la paradoja de reflexividad de Soros (idea original de William Thomas) o de la profecía autocumplida, especialmente en la incipiente Edad de los algoritmos, si suficientes inversores siguen la misma estrategia, independientemente de su validez.

El señor Popper no tendría mucho problema para buscar maneras de refutar esta y otras teorías pese a que sus predicciones puedan llegar a acertar durante muchos años más. Sería especialmente crítico, como con el psicoanálisis, por considerar que una teoría no explica realmente nada si acaba incluyendo a su cuerpo cualquier situación que la falsaría, no aceptando por tanto elementos claros para su falsación. Nos diría seguramente que la burbuja de las .com por sí misma falsa la teoría del momento, y que todo lo que sigue a la primera definición (sencilla, audaz y altamente falsable) son extensiones adhoc que restan credibilidad y valor. Quizás en otro artículo se pueda profundizar en tales revisiones y el riesgo de proteger ad eternum un dogma.

Con esto en mente es posible que, al final, el verdadero valor no esté en confiar en un futuro predecible (y lucrativo), sino en prepararse para convivir con su incertidumbre, ser humildes sobre las limitaciones del conocimiento y conscientes de las debilidades de nuestras herramientas. Con lo expuesto hasta ahora quizá usted también pueda ser como Popper y desafiar las creencias, o como Hume y buscar lógica en su toma de decisiones, convirtiendo así este conocimiento que era a priori inútil, sólo quizás, en algo de utilidad.